KI und Ingenieurwissen, Trainingsdaten und der Wert von Unsicherheiten

Alexander Kunz

11.03.2025

Künstliche Intelligenz und Simulation aus Anwendersicht

CADFEM trifft … Kevin Cremans, einen der Gründer des KI-Startups PI Probaligence und Kopf hinter der KI-Lösung STOCHOS. Im Gespräch gibt er Einblicke, was wichtig ist, wenn Unternehmen Künstliche Intelligenz im Bereich Simulation und Digital Engineering einsetzen wollen. Dabei nimmt er in diesem Teil die Perspektive des Anwenders, des Simulationsingenieurs ein. Kevin Cremans skizziert, was die KI-Lösung STOCHOS auszeichnet und wie sie an den produktiven Einsatz im Bereich der Simulation herangeführt wird. Ein Gespräch über die Notwendigkeit von Ingenieurwissen, Implementierungswege und die Vorteile probabilistischer Methoden.

Kevin, ChatGPT hat einen KI-Hype ausgelöst. Plötzlich war KI anwendbar, erlebbar. Wie ist es dir dabei ergangen?

ChatGPT ist bekanntlich eine KI, die jeder nutzen kann, auch im privaten Umfeld. Sie hat mich genauso begeistert wie alle anderen. Was viele nicht wissen: Die Grundlagen für das, was man heute KI nennt, wurden schon in den 1950er-Jahren gelegt, seitdem wird an neuronalen Netzen gearbeitet. Schwung aufgenommen haben die Methoden mit der wachsenden Hardwareleistung und den sehr, sehr vielen Daten, die eine digitalisierte Welt hervorbringt.

Stichwort Daten: Sie sind entscheidend für KI und Maschinelles Lernen. Wie kommt man speziell in der Simulation zu validen Trainingsdaten?

Schwierige Frage, denn es hängt sehr von der Aufgabenstellung ab. Was ich aber bei der Simulation sagen kann, ist: Der Domainexperte, also der Simulationsprofi für Mechanik oder für Strömung, muss bei der Erzeugung von Daten und Datensätzen sehr genau hinschauen. Denn wenn sich etwa Bauteile stark ändern und dann das Netz nicht mehr passt, werden Ergebnisse schnell unplausibel. Das wird dann gerne auf die KI geschoben, obwohl sie gar nichts dafür kann. Übrigens ist die KI damit auch ein gutes Werkzeug, um die Datenqualität zu überprüfen: Wenn sie einen Zusammenhang nicht lernen kann, ist das ein Indiz für unzureichende Trainingsdaten.

Man muss sich also schon sehr klar sein über den Use Case einer Simulation, den man mit KI lösen möchte. Gerade zum Einstieg ist Beratung essenziell, damit die KI nach der Implementierung verlässliche Ergebnisse liefert, oder?

Das kann ich bestätigen. In Kundengesprächen zeigt sich manchmal, dass teilweise noch ganz falsche Vorstellungen von KI herrschen. Das liegt auch daran, dass sich viele an dem orientieren, was sie bei ChatGPT erleben. Daher ist es wichtig, miteinander zu reden: Was ist mit KI möglich, was nicht, wo sind die Grenzen, was kann ich erwarten? Und wie du schon sagst, dass man schon vorher konkrete Ziele absteckt, damit nachher der Erfolg auch messbar ist.

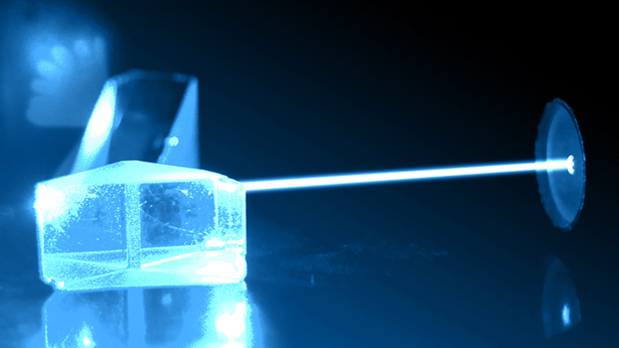

Optical simulation

Precision & efficiency combined. Find out in our webinars and further information how you can develop your optical designs with maximum precision.

Ansys Startup Program: simulation for startups

Take advantage of the best in simulation technology, right from the start of your business, with a reduced investment.

KI-Insights für Anwender: Daten erzeugen und validieren

Daten sind die Grundlage für das Maschinelles Lernen. Wie können Anwender gute und valide Trainingsdaten erzeugen? Und wie können Anwender die Ergebnisse ein bereits trainierten KI überprüfen? Welche Möglichkeiten gibt es, KI-Lösungen in bestehende Workflows zu integrieren?

Es hilft also, klein anzufangen. Das heißt, man setzt einen einfachen Use Case auf und skaliert ihn dann?

Gerade bei diesem Thema sind zunächst einmal kleine Schritte zu empfehlen. An einfachen Use Cases sieht man, was funktioniert und bekommt ein Gefühl, was möglich ist. Darauf lässt sich dann aufbauen. Dieser Weg ist auch gut die Akzeptanz von KI innerhalb des Unternehmens.

Kann ich Machine Learning schon beim Erzeugen von Datensätzen anwenden?

Ja, dafür gibt es Methoden, die wir in STOCHOS integriert haben. Wir lassen dadurch die KI selbst definieren, welche Datenpunkte ihr am meisten beim Lernen helfen. Das ist ein Unterschied zum klassischen DoE, wo sehr viele Datenpunkte auf einmal generiert werden, von denen die Hälfte oft gar nicht notwendig gewesen wäre. Oder wo man feststellt, dass Parameter vergessen wurden und deshalb nochmal vor vorne anfangen werden muss.

Bei der adaptiven Herangehensweise sagt unser Modell: ‚Ich brauche für das Design diese Geometrie, weil ich hier noch Wissenslücken habe. Bitte generiere folgenden Datenpunkt, der mir sehr hilft.‘ Auf diese Weise erzeugen wir nur so viele Datenpunkte, wie für ein gutes Modell notwendig sind. Das funktioniert nur mit probabilistischen Modellen. Aber genau das macht unsere Lösung STOCHOS aus: Wir haben Modelle, die Unsicherheiten vorhersagen können. Und wir können das Modell fragen: Wo bist du am unsichersten? Und dann dort einen Datenpunkt generieren lassen.

Dann habe ich die KI trainiert. Wie kann ich nun die Ergebnisse überprüfen?

Hier ist wieder der Domainexperte gefragt. Er sollte mit dem Modell ein bisschen herumspielen und schauen, ob das, was das Modell vorhersagt, plausibel ist. Natürlich gibt es dafür auch Techniken, also Methoden wie z. B. die Kreuzvalidierung, wo man die Trainingsdaten mehrfach aufteilt in Trainings- und Testdatenpunkte und dann das Modell damit trainiert. Testdatenpunkte sind Punkte, die dem Modell nicht zum Trainieren gegeben wurden und die sich deshalb gut eignen, um zu überprüfen, wie gut es ist.

Auch hier kommt wieder das Probabilistische ins Spiel. Denn bei STOCHOS ist es so: Bei jeder Vorhersage, auch später, beim produktiven Einsatz, wird ein Konfidenzintervall ausgegeben. Wenn ein Modell nachträglich verändert wurde und eine Vorhersage macht, die stark von den antrainierten Werten abweicht, dann würde unser Modell sagen: ‚Ich bin hier sehr unsicher mit der Vorhersage, besser wäre es, wenn du das noch mal simulierst‘.

Wir können sogar auf dem Bauteil darstellen, an welchen Stellen beispielsweise das Spannungsfeld besonders unsicher ist. Und das ist sehr wichtig. Denn bei klassischen, d.h. nicht probabilistischen Machine Learning Verfahren, also bei neuronalen Netzen beispielsweise, kriegt man einfach nur eine Vorhersage und bleibt im Unklaren, wie verlässlich das Ergebnis ist. Und das ist natürlich problematisch.

Wenn ich sehe, dass mein Modell gut ist, funktioniert und ich es produktiv einsetzen will, wie implementiere ich es dann?

Wenn man sicher ist, dass es passt, dann geht es ans Deployment. Abhängig von der Aufgabenstellung gibt es mehrere Möglichkeiten dafür, hier kommt dann auch Ihr von CADFEM und eure Digital Engineering-Expertise wieder als Ratgeber ins Spiel. Das kann beispielsweise über eine WebApp gehen oder die direkte Integration in einen bestehenden Workflow. Wir selbst bieten hier eine Python-Bibliothek an, die relativ einfach in vorhandene Prozesse eingebunden werden kann. Mit einer Zeile Code kann aus STOCHOS heraus eine WepApp exportiert werden.

KI für Ingenieure in Simulation und Produktentwicklung

Lernen Sie was hinter aktuellen KI-Technologien steckt, welche Trends es gibt und wie Sie KI bei Ihren Simulationsaufgaben anwenden können.

![ai-for-engineers-in-simulation-and-product-development-21202[1]](https://blog.cadfem.net/hubfs/02_TOPICS/DE_Corporate%20Newsletter/06-November%202024/ai-for-engineers-in-simulation-and-product-development-21202%5B1%5D.jpg)

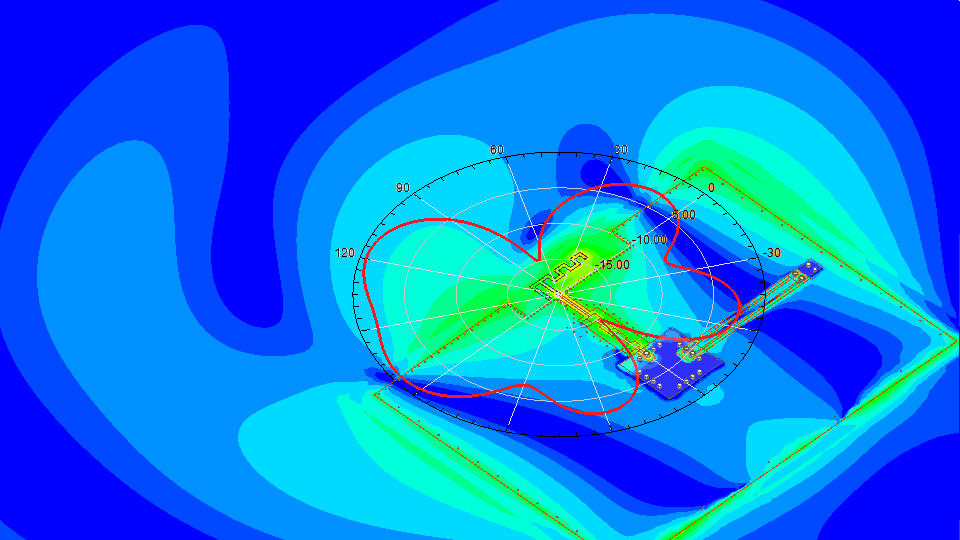

Ansys HFSS

Industry standard for determining the radiation and transmission behavior of high-frequency electromagnetic fields.